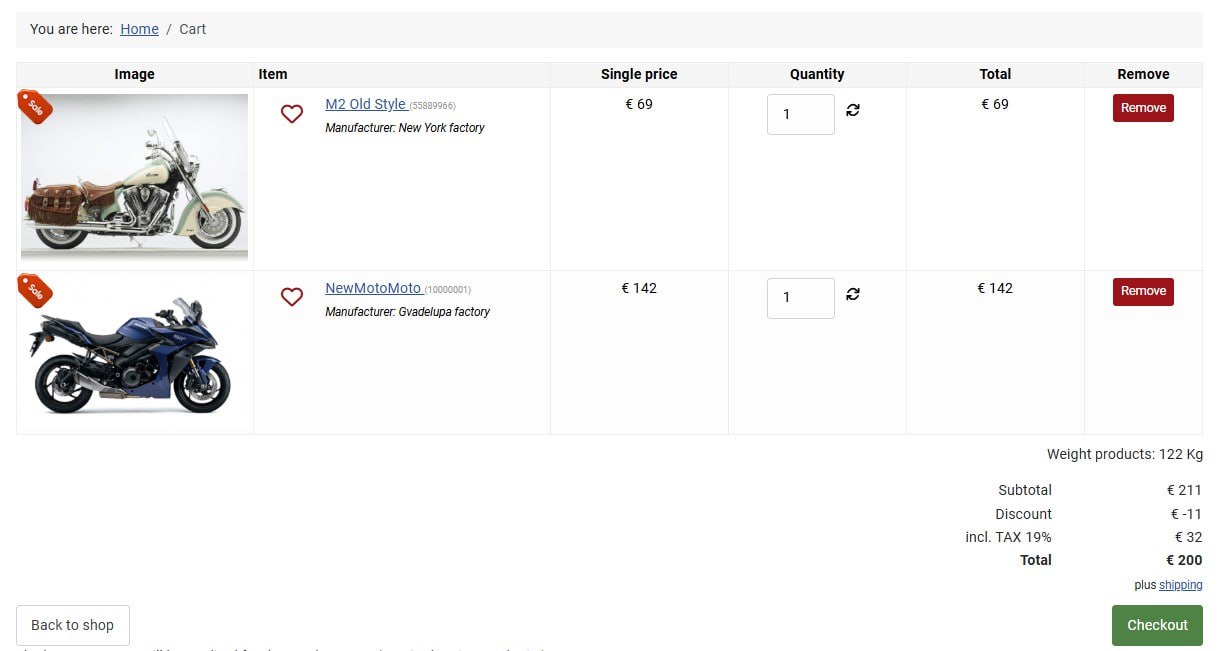

?page=shop.browse&category_id=15

?page=shop.product_details&flypage=flypage.tpl&product_id=50&category_id=15

роботс выше для сайт где стоит sh404

-------------

роботс для сайтов без чпу я не собирала

вам не подойдет этот роботс, у вас адреса не чпу и имеют вид

?page=shop.browse&category_id=15

?page=shop.product_details&flypage=flypage.tpl&product_id=50&category_id=15

роботс выше для сайт где стоит sh404

Здравствуйте, подскажите пожалуйста, как закрыть от индексации такое

site.com/index/category/?keyword=&limitstart=

site.com/index/category/?limit=5&start=45

или можно закрыть просто все после знака ?

Disallow: /?*

так будет правильно или

Disallow: /*?

А то в индексе Google упорно сидят дубли с такими значками

Disallow: /*?*

всё индексируется, при условии что урлы ЧПУ (ну например sh404 стоит). если SEF не стоит, то практически все закроет от индексации.

вот окончательный вариант (на данный момент)Спойлер[свернуть]

katalog-tovarov.html?page=shop.product_details&flypage=flypage.tpl&product_id=183&category_id=8

katalog-tovarov.html?page=shop.product_details&flypage=flypage.tpl&product_id=183&category_id=8

И сколько страниц в индексе?

|

WT IndexNow для Joomla - отправка страниц сайта на переиндексацию в поисковики

Автор sergeytolkachyov |

Ответов: 1 Просмотров: 1387 |

от sergeytolkachyov |

|

Каким плагином можно закрыть внешние ссылки?

Автор gorbi_U |

Ответов: 4 Просмотров: 3732 |

от olegon |

|

Странные дубли

Автор Lemonez |

Ответов: 3 Просмотров: 3507 |

от Alexeyman |

|

Роботу Googlebot заблокирован доступ в файле robots.txt

Автор illimited |

Ответов: 3 Просмотров: 4337 |

от web1 |

|

Как сделать правильный редирект

Автор gadjet |

Ответов: 25 Просмотров: 14053 |

от kabban |